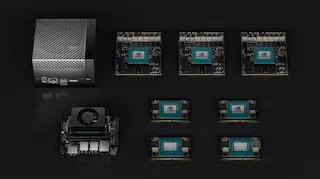

NVIDIA Jetson Orin

KI-Lösungen für Robotik und Edge-Anwendungen

Die Jetson Orin-Module bieten starke Rechenleistung für den Einsatz in Bereichen wie generative KI, Edge-Computing und autonome Systeme.

In unserem News-Blog halten wir Sie stets auf dem Laufenden über die neuesten Entwicklungen und Trends in der IT-Welt. Hier finden Sie aktuelle Informationen zu unseren innovativen Lösungen und Dienstleistungen, spannende Einblicke in Projekte und Erfolge sowie wertvolle Tipps rund um IT-Infrastrukturen, Cloud-Lösungen, High-Performance-Computing und mehr.

Bei sysGen legen wir großen Wert darauf, Ihnen nicht nur erstklassige Produkte und Dienstleistungen zu bieten, sondern auch umfassende Informationen und Insights, die Ihnen helfen, Ihr Unternehmen voranzubringen. Unser Blog ist Ihre Anlaufstelle für fachkundige Beratung, inspirierende Erfolgsgeschichten und praktische Anleitungen.

Die Jetson Orin-Module bieten starke Rechenleistung für den Einsatz in Bereichen wie generative KI, Edge-Computing und autonome Systeme.

Durch die Integration von NVIDIAs leistungsstarker Hardware, spezialisierten SDKs und umfangreichen Entwickler-Tools können Software-Entwicklungsteams ihre Arbeitsabläufe beschleunigen, die Zeit bis zur Marktreife verkürzen und anspruchsvollere, leistungsgesteuerte Anwendungen erstellen. Ob für KI, HPC, Data Science oder 3D-Grafik - NVIDIA bietet umfassende Ressourcen, um die Entwicklung zu optimieren und neue Möglichkeiten in der Software zu erschließen.

Ein herzliches Dankeschön an alle, die uns an unserem Stand K31 besucht haben! Wir freuen uns darauf, die Gespräche fortzusetzen, neue Projekte zu entwickeln und gemeinsam die Zukunft der Raumfahrt zu gestalten. Bis nächstes Jahr – wir sehen uns wieder auf der Space Tech Expo 2025!

Die steigenden Datenmengen und die Anforderungen an Rechenzentren nehmen kontinuierlich zu, da Workloads zunehmend komplexer werden und neue Technologien wie Künstliche Intelligenz (KI) immer höhere Anforderungen an die Infrastruktur stellen. Ein Drittel aller jährlich ausgelieferten Rechenzentrumsserver unterstützt softwaredefinierte Rechenzentrums-Stacks, die nur mit einer zukunftsfähigen Netzwerkinfrastruktur reibungslos laufen können. NVIDIA bietet Lösungen, die eine solche robuste, performante und sichere Infrastruktur ermöglichen.

Erlebe den Durchbruch in der KI-Entwicklung! Unsere neueste Case Study beleuchtet, wie Jina AI in Zusammenarbeit mit der sysGen GmbH die Zukunft der neuronalen Suche revolutioniert. Dank leistungsstarker NVIDIA H100 GPUs werden Such- und Reranking-Modelle auf ein neues Niveau gehoben. Erfahre hier, wie diese Technologie die Effizienz und Genauigkeit in Bereichen wie Gesundheitsberatung und Kundenbetreuung drastisch verbessert. Neugierig geworden? Jetzt lesen und mehr erfahren

Erfahren Sie mehr über unsere Dienstleistungen und wie wir Ihr Unternehmen unterstützen können.

Kontaktieren Sie uns für eine individuelle Beratung!